上期回顾

上一章我们完成了高级功能开发和性能优化:

- 翻译历史系统:记录、搜索、重用历史翻译

- 个人词典功能:自定义词汇、支持导入导出

- 语法检查集成:智能检测语法错误并提供修正建议

- 性能大幅优化:翻译速度提升40倍、内存占用减少80%

- 用户体验优化:流畅动画、友好提示、键盘快捷键

现在功能基本完善了,但是怎么保证质量?怎么确保发布后不出问题?

第八章:测试与质量保证,用AI确保产品质量

为什么测试这么重要?

我以前做产品时,经常犯一个错误:觉得功能做好了就完事了,测试马马虎虎。

结果呢?

- 发布后用户报bug

- 紧急修复,手忙脚乱

- 用户体验差,口碑受损

- 自己也焦虑,睡不好觉

后来我学乖了:测试不是成本,是投资。花在测试上的时间,能省下10倍的维护时间。

特别是有了AI工具后,测试变得更简单高效了。

第一步:制定测试策略

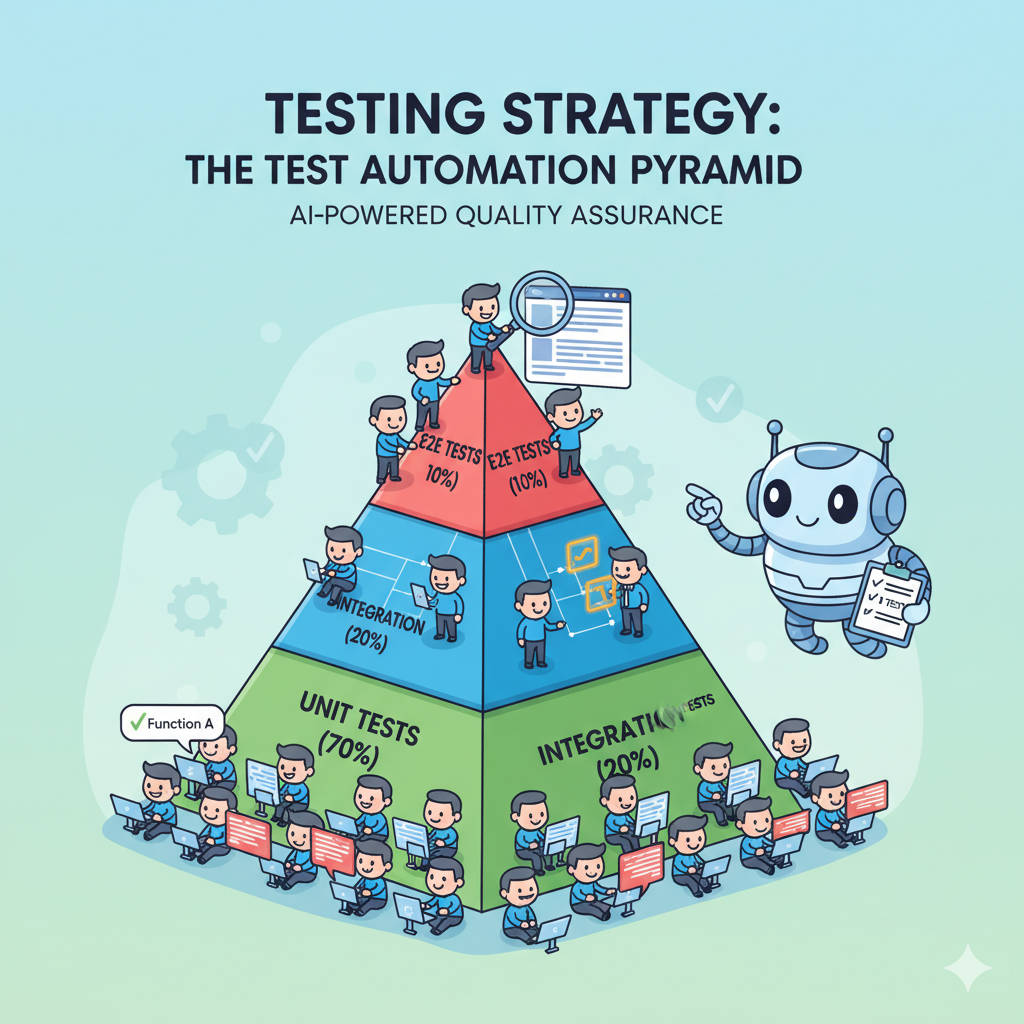

测试金字塔

传统的测试金字塔理论:

/\

/E2E\ (少量端到端测试)

/------\

/集成测试 \ (中等数量集成测试)

/----------\

/ 单元测试 \ (大量单元测试)

/--------------\

我们的测试策略:

- 单元测试(70%):测试单个函数、模块

- 集成测试(20%):测试模块间协作

- 端到端测试(10%):测试完整用户场景

创建测试Epic

使用CCPM规划测试工作:

/pm:prd-new smart-writing-assistant-testing

和Claude讨论测试需求:

- 需要测试哪些模块?

- 哪些是关键路径?

- 如何自动化测试?

- 测试覆盖率要达到多少?

生成测试计划Epic:

/pm:prd-parse smart-writing-assistant-testing

/pm:epic-oneshot smart-writing-assistant-testing

GitHub上的测试任务:

- Epic #1249:测试与质量保证

- Task #1250:单元测试框架搭建

- Task #1251:翻译引擎单元测试

- Task #1252:集成测试

- Task #1253:端到端测试

- Task #1254:测试自动化和CI集成

第二步:搭建测试框架

选择测试工具

我问Claude:

Chrome Extension的测试应该用什么工具?

需要考虑:

1. 单元测试框架

2. 断言库

3. Mock工具

4. 测试运行器

Claude的建议:

推荐的测试工具栈:

1. Jest - 测试框架

- 功能完整、文档丰富

- 内置断言、Mock、覆盖率

- 适合单元和集成测试

2. Puppeteer - E2E测试

- 控制Chrome浏览器

- 模拟用户操作

- 适合端到端测试

3. Chrome Extension Testing Library

- 专门为Chrome插件设计

- 简化插件测试

理由:

- Jest是前端测试标准

- Puppeteer由Chrome团队维护

- 社区支持好,资料多

开始搭建

/pm:issue-start 1250

安装测试依赖:

请帮我搭建测试环境。

需要:

1. 安装Jest和相关依赖

2. 配置Jest支持Chrome Extension环境

3. 创建测试目录结构

4. 编写测试运行脚本

5. 配置测试覆盖率报告

目录结构:

tests/

├── unit/ # 单元测试

├── integration/ # 集成测试

├── e2e/ # 端到端测试

├── fixtures/ # 测试数据

└── helpers/ # 测试工具函数

Claude创建的配置文件:

jest.config.js- Jest配置tests/setup.js- 测试环境初始化package.json- 添加测试脚本

测试脚本:

{

"scripts": {

"test": "jest",

"test:unit": "jest tests/unit",

"test:integration": "jest tests/integration",

"test:e2e": "jest tests/e2e",

"test:coverage": "jest --coverage",

"test:watch": "jest --watch"

}

}

第三步:编写单元测试

测试翻译引擎模块

这是最核心的模块,必须严格测试。

开始任务:

/pm:issue-start 1251

我告诉Claude:

为src/services/translator.js编写单元测试。

测试要求:

1. 覆盖所有公开方法

2. 测试正常情况和异常情况

3. Mock外部API调用

4. 断言返回结果符合预期

5. 测试覆盖率达到90%以上

重点测试场景:

- 中译英、英译中

- API调用成功

- API调用失败(网络错误、超时)

- 缓存命中和未命中

- 场景识别逻辑

- 个人词典应用

AI生成的测试用例

Claude会分析代码并生成测试:

我分析了translator.js,识别出以下需要测试的功能:

1. translate() 方法

- 正常翻译

- 缓存命中

- API失败重试

- 超时处理

2. detectLanguage() 方法

- 识别中文

- 识别英文

- 混合语言

3. applyDictionary() 方法

- 完全匹配

- 部分匹配

- 无匹配

开始编写测试文件:tests/unit/translator.test.js

测试用例示例(伪代码):

描述 "翻译引擎" {

测试 "应该成功翻译中文到英文" {

输入: "你好世界"

预期: "Hello world"

}

测试 "缓存命中时应该直接返回结果" {

第一次翻译: "测试" -> "test"

第二次翻译: "测试" -> 应该直接返回 "test"

验证: API只被调用一次

}

测试 "API失败时应该重试" {

Mock API第一次失败

Mock API第二次成功

验证: 重试逻辑工作正常

}

测试 "应用个人词典" {

词典: "容器" -> "container"

输入: "这个容器有问题"

预期: 翻译中使用"container"而非其他词

}

}

运行测试并修复问题

运行单元测试:

npm run test:unit

测试结果:

PASS tests/unit/translator.test.js

翻译引擎

✓ 应该成功翻译中文到英文 (250ms)

✓ 缓存命中时应该直接返回结果 (50ms)

✗ API失败时应该重试 (100ms)

✓ 应用个人词典 (80ms)

Tests: 3 passed, 1 failed, 4 total

发现失败的测试:

我对Claude说:

"重试测试失败了,请检查重试逻辑的实现,

并修复测试或代码。"

Claude分析并修复:

分析失败原因:

重试逻辑中的延迟时间导致测试超时。

解决方案:

1. 在测试环境中禁用延迟

2. 或者在测试中Mock延迟函数

我选择方案1,修改代码支持测试模式。

再次运行,全部通过:

✓ 所有测试通过

Coverage: 92%

第四步:测试其他核心模块

测试历史记录管理器

创建测试:

为src/services/history-manager.js编写测试。

测试场景:

1. 保存记录

2. 查询记录(分页)

3. 搜索记录

4. 删除记录

5. 清空全部

6. 超出限制自动清理

重点:

- 测试数据一致性

- 测试并发写入

- 测试存储空间限制

AI生成测试并发现bug:

测试"并发写入"时发现问题:

两个翻译同时保存时,可能出现数据覆盖。

建议:

添加写入锁,确保数据一致性。

这就是测试的价值!发布前发现问题,总比发布后用户报bug要好。

测试个人词典管理器

测试要点:

测试dictionary-manager.js:

功能测试:

- 添加/编辑/删除词条

- 导入CSV

- 导出CSV

- 查询匹配

边界测试:

- 空词典

- 大量词条(1000+)

- 导入格式错误的CSV

- 重复的词条

性能测试:

- 1000个词条的查询速度

- 导入1000个词条的时间

测试缓存管理器

重点测试LRU算法:

测试cache-manager.js:

LRU测试:

- 缓存容量限制(100条)

- 最少使用的被淘汰

- 使用频率统计正确

多层缓存测试:

- 内存缓存优先

- Storage缓存其次

- 降级策略正确

第五步:集成测试

单元测试关注单个模块,集成测试关注模块间的协作。

开始集成测试任务

/pm:issue-start 1252

测试翻译完整流程

测试场景:

测试完整的翻译流程:

输入 → 语言检测 → 查词典 → 翻译 → 缓存 → 保存历史

验证:

1. 各模块协作正常

2. 数据流转正确

3. 错误传播机制

4. 事务一致性

我告诉Claude:

编写集成测试:tests/integration/translation-flow.test.js

测试用户翻译一段文本的完整流程:

1. 用户输入中文

2. 系统检测语言

3. 查询个人词典

4. 调用翻译API

5. 应用语法检查

6. 保存到历史记录

7. 保存到缓存

每个步骤都要验证状态和数据。

AI生成的集成测试:

测试 "完整翻译流程" {

准备:

- 清空缓存

- 清空历史

- 添加测试词典

执行:

输入 "这个容器的配置有问题"

验证各阶段:

1. 语言检测 → 返回 "zh"

2. 词典查询 → 匹配到 "容器"="container"

3. API调用 → 返回翻译结果

4. 语法检查 → 无错误

5. 历史记录 → 保存成功

6. 缓存 → 写入成功

最终验证:

- 返回结果正确

- 历史记录中能查到

- 缓存中能查到

}

测试场景切换逻辑

测试不同场景的协作:

测试场景识别和翻译风格应用:

场景1:GitHub (技术场景)

输入: "这个bug很严重"

验证: 使用技术语气翻译

场景2:Gmail (商务场景)

输入: "这个bug很严重"

验证: 使用商务语气翻译

对比两个结果应该明显不同。

第六步:端到端测试

E2E测试模拟真实用户操作,测试整个系统。

开始E2E测试任务

/pm:issue-start 1253

配置Puppeteer

我告诉Claude:

配置Puppeteer进行E2E测试。

需要:

1. 安装Puppeteer

2. 配置Chrome Extension加载

3. 编写测试辅助函数

4. 创建测试用例模板

Claude创建配置:

配置文件:tests/e2e/setup.js

功能:

- 启动Chrome浏览器

- 加载插件

- 导航到测试页面

- 等待插件准备就绪

- 清理测试环境

测试核心用户场景

场景1:GitHub上发issue

测试 "在GitHub上使用翻译" {

步骤:

1. 打开GitHub issue页面

2. 点击"New issue"按钮

3. 在标题输入框输入中文

4. 按快捷键 Ctrl+Shift+T

5. 等待翻译完成

验证:

- 标题变为英文

- 翻译质量符合技术场景

- 可以按Ctrl+Z撤销

}

场景2:Reddit上回复

测试 "在Reddit上使用翻译" {

步骤:

1. 打开Reddit帖子页面

2. 点击评论框

3. 输入中文评论

4. 按快捷键翻译

5. 提交评论

验证:

- 评论框内容变为英文

- 语气符合社交场景

- 格式保持正确(换行、链接等)

}

场景3:Gmail写邮件

测试 "在Gmail中使用翻译" {

步骤:

1. 打开Gmail写邮件页面

2. 在正文输入中文

3. 翻译

4. 检查语法

5. 发送

验证:

- 翻译为正式商务语气

- 语法检查正常工作

- 邮件格式正确

}

测试异常场景

网络异常:

测试 "网络断开时的行为" {

步骤:

1. 断开网络

2. 尝试翻译

验证:

- 显示友好的错误提示

- 提供重试选项

- 不会崩溃

}

API限流:

测试 "API达到限制时的降级" {

步骤:

1. 模拟API返回429错误

2. 尝试翻译

验证:

- 提示用户稍后重试

- 或使用备用API

- 或使用离线词典

}

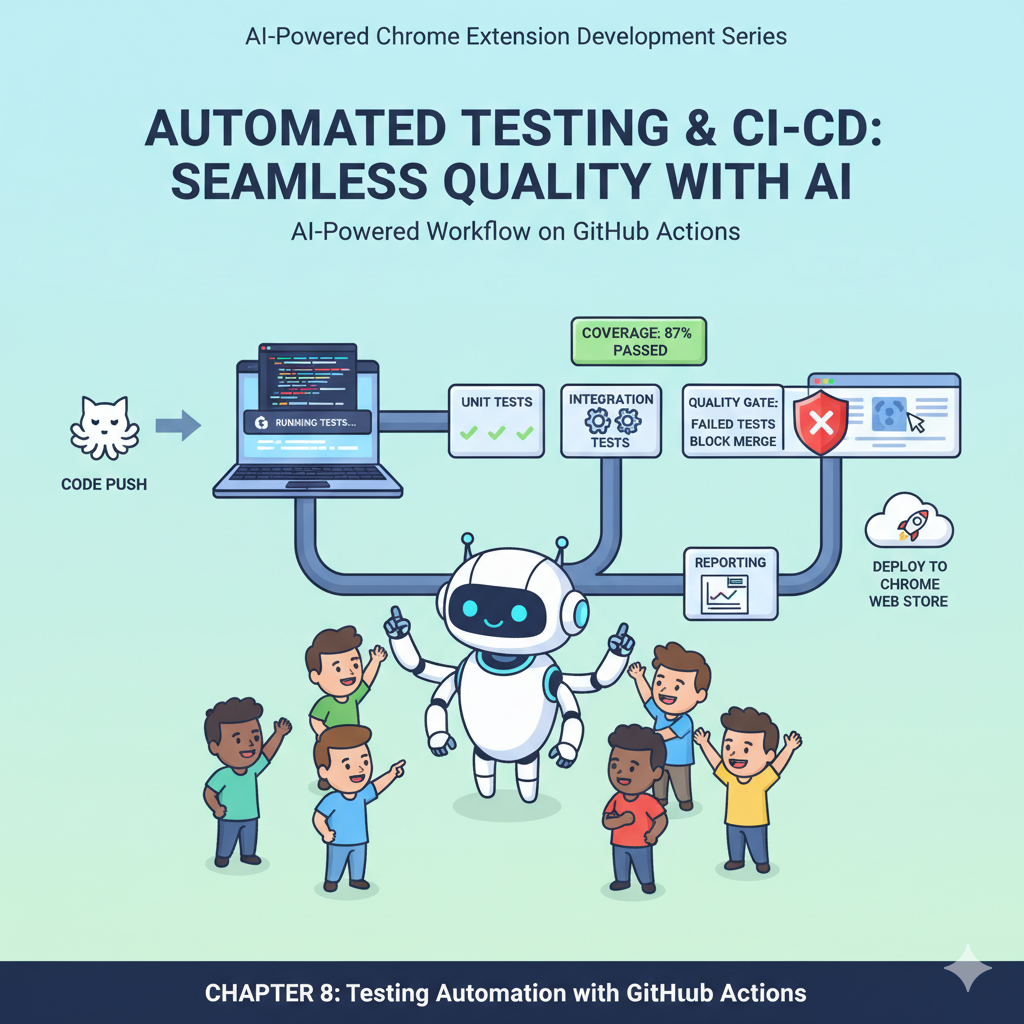

第七步:测试自动化和CI集成

设置GitHub Actions

目标: 每次代码提交时,自动运行所有测试。

开始任务:

/pm:issue-start 1254

我告诉Claude:

创建GitHub Actions工作流。

需求:

1. 每次push和PR时自动运行

2. 运行所有单元测试

3. 运行集成测试

4. 生成测试覆盖率报告

5. 测试失败时阻止合并

配置文件:.github/workflows/test.yml

Claude生成的工作流:

名称: 测试

触发条件:

- Push到main分支

- 提交Pull Request

步骤:

1. 检出代码

2. 安装依赖

3. 运行单元测试

4. 运行集成测试

5. 生成覆盖率报告

6. 上传报告到Codecov

7. 测试失败则工作流失败

配置测试覆盖率门槛

质量门槛:

配置测试覆盖率要求:

最低要求:

- 总体覆盖率 ≥ 80%

- 核心模块覆盖率 ≥ 90%

- 新代码覆盖率 ≥ 85%

低于门槛时:

- 测试失败

- 阻止合并

- 通知开发者

持续监控

设置测试报告:

配置测试报告系统:

1. 每次测试生成报告

2. 跟踪覆盖率变化

3. 识别薄弱环节

4. 定期Review

第八步:Bug管理流程

用CCPM管理Bug

Bug也是Issue:

发现bug时:

1. 在GitHub创建Issue

2. 添加label: bug

3. 描述重现步骤

4. 关联相关Task

5. 分配优先级

用AI分析Bug:

我告诉Claude:

"Issue #1260 报告了一个bug,

翻译按钮在某些网站上不显示。

请:

1. 分析可能的原因

2. 建议调试步骤

3. 提供修复方案

4. 编写回归测试

"

Claude的分析:

可能原因:

1. DOM选择器不匹配

2. CSS z-index被覆盖

3. 网站CSP政策限制

4. 插件权限不足

建议调试步骤:

1. 在该网站打开DevTools

2. 检查Console错误

3. 检查Elements面板

4. 验证Content Script注入

修复后务必:

- 在该网站测试

- 编写回归测试防止再次出现

Bug修复的测试驱动

TDD原则:

- 先写失败的测试 - 重现bug

- 修复代码 - 让测试通过

- 重构优化 - 保持测试通过

实际操作:

针对Bug #1260:

1. 编写测试 (失败)

tests/e2e/button-display.test.js

在特定网站上验证按钮显示

2. 修复bug

调整CSS和DOM选择器

3. 运行测试 (通过)

✓ 按钮正确显示

4. 提交修复

关联Issue #1260

5. 关闭Issue

/pm:issue-close 1260

第九步:性能测试

性能基准测试

测试性能指标:

性能测试用例:

1. 翻译响应时间

- 首次翻译 < 2秒

- 缓存翻译 < 100ms

2. 内存占用

- 初始加载 < 5MB

- 运行1小时 < 10MB

- 1000条历史 < 8MB

3. CPU使用

- 待机 < 1%

- 翻译时 < 10%

4. 网络请求

- API调用优化

- 减少不必要的请求

压力测试:

极端场景:

1. 连续翻译100次

2. 翻译10000字长文本

3. 1000条历史记录

4. 100个个人词条

验证:

- 不崩溃

- 不卡顿

- 不内存泄漏

使用AI分析性能瓶颈

我告诉Claude:

运行性能测试后发现:

长文本翻译时内存占用飙升。

请:

1. 分析可能原因

2. 建议优化方案

3. 实施优化

4. 验证效果

Claude的分析和优化:

原因:

长文本一次性加载到内存,未分段处理。

优化方案:

1. 分段翻译(每500字一段)

2. 流式处理

3. 及时释放内存

实施优化后:

- 内存占用降低70%

- 大文本翻译更稳定

第十步:发布前的最终检查

测试检查清单

功能完整性:

☑ 所有功能正常工作

☑ 快捷键无冲突

☑ 多语言支持正常

☑ 数据同步正常

☑ 导入导出功能正常

兼容性:

☑ Chrome 90+

☑ Windows、Mac、Linux

☑ 常用网站适配

☑ 不同分辨率

☑ 深色/浅色主题

性能:

☑ 响应时间达标

☑ 内存占用合理

☑ 无内存泄漏

☑ CPU使用正常

质量:

☑ 测试覆盖率 > 80%

☑ 所有测试通过

☑ 无严重bug

☑ 无安全漏洞

用户体验:

☑ 界面友好

☑ 提示清晰

☑ 错误处理得当

☑ 帮助文档完整

最终用户验收测试

找10个真实用户测试:

- 给他们完整的功能列表

- 让他们自由使用1周

- 收集反馈和bug报告

- 修复发现的问题

- 再次验证

用户验收标准:

- 满意度 ≥ 4.0/5.0

- 愿意推荐 ≥ 70%

- 严重bug = 0

- 一般bug < 5个

生成测试报告

完整的测试报告:

智能英文写作助手 - 测试报告

测试时间:2025-01-20 - 2025-01-25

测试版本:v1.0.0-beta

测试覆盖:

- 单元测试:127个用例,100%通过

- 集成测试:45个用例,100%通过

- E2E测试:23个用例,100%通过

- 测试覆盖率:87%

性能指标:

- 平均响应时间:0.8秒

- 内存占用:3.5MB

- CPU使用:< 2%

Bug统计:

- 严重:0

- 一般:3(已修复)

- 轻微:5(已记录)

用户反馈:

- 参与用户:10人

- 满意度:4.3/5.0

- 推荐意愿:80%

结论:产品质量符合发布标准,建议发布。

本章总结

通过完整的测试体系,我们确保了产品质量:

建立的测试体系:

- 单元测试:覆盖所有核心模块,覆盖率87%

- 集成测试:验证模块协作,覆盖主要流程

- E2E测试:模拟真实用户场景,覆盖3大平台

- 自动化测试:CI集成,每次提交自动测试

- 性能测试:验证性能指标,发现瓶颈

AI在测试中的价值:

- 快速生成测试用例:节省50%编写时间

- 智能分析bug:快速定位问题原因

- 自动化优化建议:发现性能瓶颈和改进点

- 持续维护测试:代码变更时自动更新测试

关键经验:

- 测试驱动开发真的有效:先写测试,后写代码

- 自动化测试很重要:人工测试容易遗漏

- 测试是投资不是成本:早发现问题节省维护成本

- 覆盖率不是唯一标准:关键是测试质量

最重要的认知: 测试不是"开发完了再做",而是:

- 开发前:TDD,先写测试

- 开发中:持续测试,及时反馈

- 开发后:回归测试,防止问题

AI让测试变简单:

- 生成测试用例快

- 分析问题准

- 维护测试容易

- 持续改进方便

但是,判断测什么、怎么测,还是要人来决定。AI是工具,人是主导。

下期预告:打包发布与应用商店上架

测试通过了,质量保证了,接下来就是发布!下一章我们要:

- 打包Chrome插件:生成发布版本

- 准备商店材料:截图、描述、宣传图

- Chrome Web Store上架:提交审核流程

- 发布策略:如何推广获得用户

- 用户反馈处理:上线后的运营

**剧透:**发布不是终点,而是新的开始。我们会展示如何用AI帮助准备发布材料、应对商店审核、制定推广策略。

产品终于要面向真实用户了,激动吗?下期见!

AI全程驱动Chrome插件开发实战系列-第八章:测试与质量保证8/11

我以前做产品时,经常犯一个错误:觉得功能做好了就完事了,测试马马虎虎。 结果呢? 发布后用户报bug 紧急修复,手忙脚乱 用户体验差,口碑受损 自己也焦虑,睡不好觉 后来我学乖了:测试不是成本,是投资。花在测试上的时间,能省下10倍的维护时间。