前两天和一个做财务软件的朋友聊天,他说最近在测试一个专门给会计师事务所用的AI Agent。"刚开始挺兴奋的,"他说,"结果用了两天就不敢碰了。"

怎么回事?原来这个AI在回答税务问题时,经常给出看似专业但实际错误的建议。比如问到"高新技术企业研发费用加计扣除的具体标准",AI信心满满地回答了一堆,但细节上有好几处跟最新政策不符(他当时就在心里想:这要是直接用到客户项目上,出了问题谁负责?)。

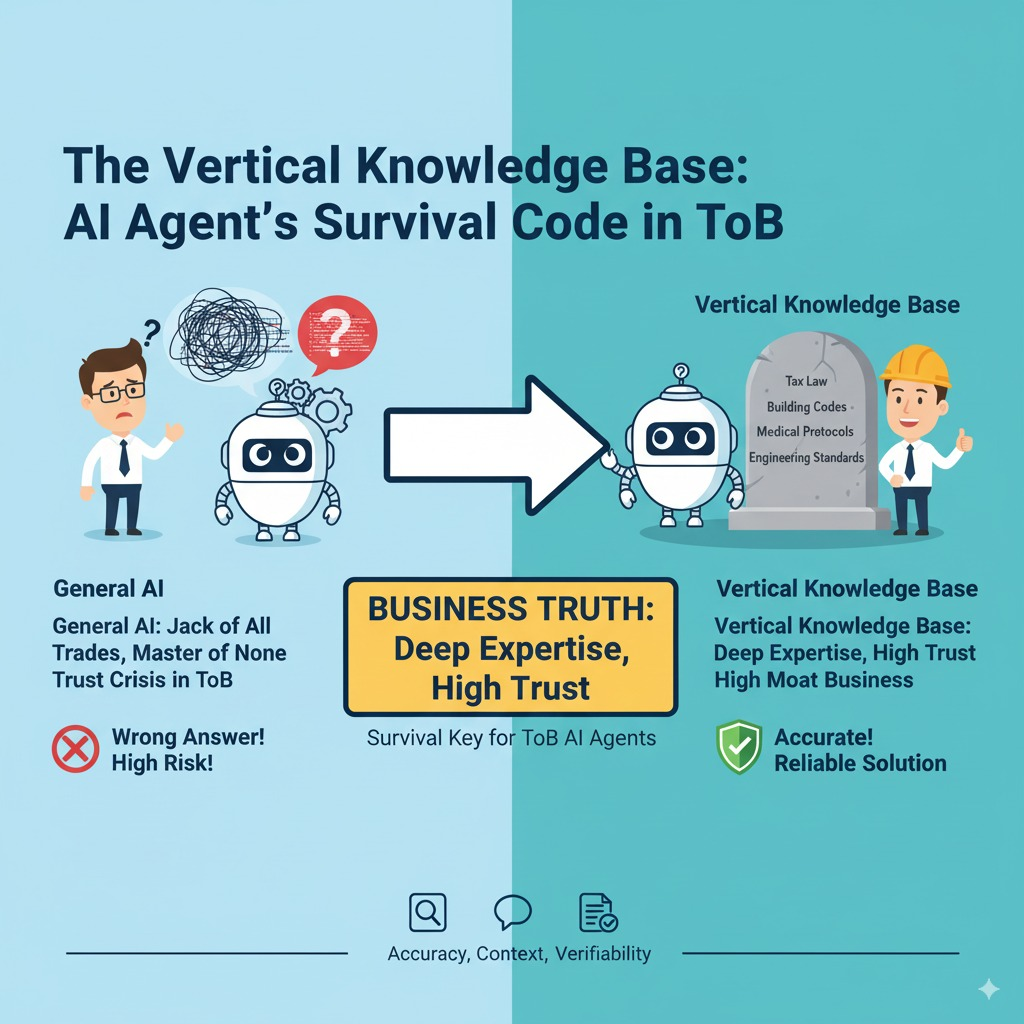

这个场景其实揭示了ToB领域AI Agent面临的核心困境:垂直度越高的行业,AI越容易"装懂",而客户越不敢信任。

为什么会这样?想想你平时用ChatGPT的场景。问个通用问题,比如"怎么做番茄炒蛋",就算AI说得不够准确,你也能凭常识判断。但换到专业场景就不一样了——当AI跟你讲复杂的财税法规、医疗诊断建议或者工程技术标准时,你往往没有足够的知识储备去验证它说的对不对(这就像让一个外行去评判专家的话,根本没有抓手)。

更要命的是,这些垂直领域的错误成本极高。财务搞错了要补税罚款,医疗搞错了要出人命,工程搞错了要承担责任。所以哪怕AI 90%的时候都对,那10%的错误就足以让客户彻底失去信心。

但有趣的是,我最近观察到一些做得不错的AI服务商,他们的切入策略恰恰相反——不是追求大而全的通用能力,而是死磕某个垂直领域的知识库建设。

拿我知道的一家专做建筑行业的AI公司来说,他们花了整整一年时间,跟十几家设计院合作,把国标、行标、地方标准,加上这些院里积累的设计经验、常见问题库,全部整理成结构化的知识体系。成本确实不低——光是标准梳理和专家标注就花了几百万。

但效果立竿见影。现在他们的AI在回答"某地区住宅建筑防火间距要求"这类问题时,不仅能给出准确的标准条文,还能结合具体项目类型给出实用建议,甚至会提醒你注意相关的配套要求(用过的设计师都说,这比自己翻规范手册效率高太多了)。

关键在于,这种垂直知识库不是简单的资料堆砌,而是要做三件事。

内容的准确性保证必须过硬。每个知识点都要有权威来源,有版本更新机制。那家建筑AI公司就建立了一套标准跟踪系统,规范一有更新就会同步修正知识库(他们甚至会提前预告哪些标准即将修订,让客户提前准备)。

场景化的知识组织同样重要。不是把专业资料原样搬过来,而是要按照实际工作流程重新组织。比如同样是防火规范,设计阶段关注的是间距和材料选择,施工阶段关注的是具体做法和检验标准,要分别建立不同的知识索引。

可验证的答案链路也不能忽视。每个回答都要能追溯到具体的知识来源,让用户能够验证和深入了解(这样即使偶尔有错,用户也能快速发现和纠正,而不是盲目信任)。

说实话,这种做法在商业上其实很聪明。通用AI大家都在做,竞争激烈,差异化很难。但垂直知识库是个高门槛生意——既需要技术能力,更需要行业积累和客户配合,一旦建立起来就有很强的护城河。

而且从客户角度看,他们要的不是一个什么都会但什么都不精的助手,而是一个在特定领域真正专业可靠的工具。愿意为这样的价值付费,付费能力也更强(毕竟专业服务的单价本来就不低)。

当然,挑战也很明显。垂直知识库的建设周期长、投入大,需要服务商有足够的耐心和资金实力。而且每个垂直领域都相对有限,很难像通用AI那样快速规模化(这可能也是为什么很多公司还是更愿意做通用产品的原因)。

但我觉得,对于想在ToB领域立足的AI服务商来说,这可能是目前最靠谱的路径。与其在通用能力上跟巨头硬拼,不如在垂直深度上做出差异化。先在一个细分领域做到足够深、足够可信,再考虑横向扩展。

毕竟,ToB客户买的不是AI技术本身,而是能够解决实际问题的可靠方案。在这个维度上,深度往往比广度更重要(就像你找律师不会找什么都懂一点的,而是找专门擅长你那个问题的)。